Le monde numérique est en constante évolution, et un catalyseur qui différencie cette plateforme des autres est contenu généré par l'utilisateur. Bien que les entreprises du monde entier aient leurs sites Web et une présence dédiée sur les réseaux sociaux, les utilisateurs sont plus susceptibles de faire confiance aux opinions de leurs collègues clients que de se fier aux paroles de l'entreprise.

Plus de 4.26 milliards de personnes étaient des utilisateurs actifs de médias sociaux en 2021. Un nombre devrait atteindre la barre des 6 milliards d'ici 2027. La quantité de contenu généré, capturé, partagé et consommé à l'échelle mondiale a atteint 64.2 zettaoctets en 2020.

Avec de nouveaux contenus générés et consommés à un rythme effréné, il est devenu essentiel que les marques gardent un œil sur le contenu hébergé sur leurs plateformes. Plateformes en ligne doivent être et rester un environnement sûr pour leurs utilisateurs.

[A également lu: Comprendre la modération automatisée du contenu]

Qu'est-ce que la modération de contenu et pourquoi ?

Le contenu généré par les utilisateurs propulse les plateformes de médias sociaux, et modération du contenu fait référence au filtrage de ce contenu pour les messages inappropriés ou offensants. Les plateformes commerciales et de médias sociaux ont une norme spécifique pour surveiller leur contenu d'hébergement.

Les lignes directrices pourraient inclure n'importe quoi, de la violence à l'extrémisme, discours de haine, la nudité, la violation des droits d'auteur ou tout autre élément offensant. Le contenu publié sera signalé et supprimé s'il ne satisfait pas à la norme.

L'idée derrière la modération de contenu est de s'assurer que le contenu est en phase avec les idéaux de la marque et respecte les valeurs de décence, de confiance et de sécurité.

La modération du contenu est cruciale pour les entreprises afin de maintenir les normes commerciales, l'image de marque, la réputation et la crédibilité. Chaque seconde, la quantité stupéfiante de contenu généré par les utilisateurs publié sur les plateformes rend difficile pour les marques de se tenir à l'écart des propos offensants et contenu inapproprié, textes, vidéos et images. La stratégie de modération de contenu aide les marques à maintenir leur image tout en permettant aux utilisateurs de s'exprimer et en fermant les contenus offensants, explicites et violents.

Quels types de contenu pouvez-vous modérer ?

Les algorithmes de modération de contenu traitent généralement trois ou une combinaison de ces types de contenu.

Texte

La quantité de texte – des commentaires aux articles complets – qui nécessite une modération est assez stupéfiante. Les publications textuelles sont disponibles presque partout sous la forme de commentaires, d'articles, de publications sur les forums, de discussions sur les réseaux sociaux et d'autres publications.

Les algorithmes de modération du contenu textuel doivent pouvoir analyser le texte de différentes longueurs et styles à la recherche de contenu indésirable. De plus, la modération de texte peut être une tâche difficile en raison de la complexité de la langue et des nuances culturelles.

Ajouter des images

La modération d'images est beaucoup plus simple que la modération de texte, mais il est essentiel de mettre en place des directives ou des normes appropriées.

De plus, étant donné que les différences culturelles peuvent entrer en jeu lors de la modération des images, il est crucial de bien comprendre et de se connecter avec la communauté d'utilisateurs dans plusieurs zones géographiques.

Vidéos

La modération du contenu vidéo est très difficile, car la modération des vidéos peut prendre du temps, contrairement au texte ou aux images. Le modérateur doit visionner l'intégralité de la vidéo avant de la juger propre ou impropre à la consommation. Même si seules quelques images de la vidéo sont explicites ou dérangeantes, cela obligera le modérateur à supprimer tout le contenu.

Live Streaming

La diffusion en direct est peut-être le contenu le plus difficile à modérer. C'est parce que la modération de la vidéo et du texte d'accompagnement doit se produire simultanément avec le streaming.

Comment fonctionne la modération de contenu ?

Pour commencer à modérer le contenu de votre plateforme, vous devez d'abord mettre en place des normes ou des directives qui déterminent le contenu inapproprié. Ces consignes aident les modérateurs à signaler le contenu à supprimer.

Définissez le niveau de sensibilité ou le seuil que les modérateurs de contenu doivent prendre en compte lors de la révision du contenu. Le seuil doit être défini en fonction de votre marque, du type d'entreprise, des attentes des utilisateurs et de l'emplacement.

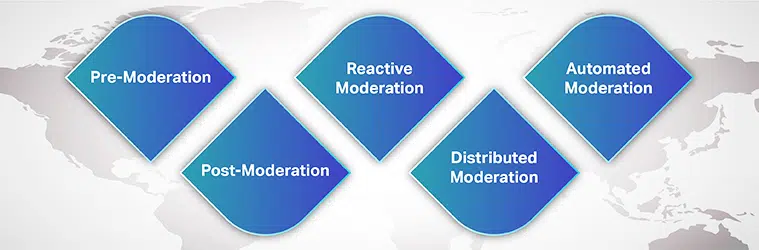

Types de modération de contenu

Vous pouvez choisir parmi de nombreux processus de modération pour les besoins de votre marque et consentement de l'utilisateur. Certains d'entre eux sont:

Pré-modération

Avant que le contenu ne soit affiché sur votre site, il est dans la file d'attente de modération. Ce n'est qu'après que le contenu a été examiné et jugé propre à la consommation qu'il est publié sur la plateforme. Bien qu'il s'agisse d'une méthode sûre pour bloquer le contenu explicite, cela prend du temps.

Post-modération

La post-modération est la méthode standard de modération de contenu où il existe un compromis entre l'engagement de l'utilisateur et la modération. Bien que les utilisateurs soient autorisés à publier leurs soumissions, elles sont toujours en attente de modération. Si le contenu a été signalé, il est examiné et supprimé. Les entreprises s'efforcent d'obtenir un temps d'examen plus court afin que le contenu inapproprié ne soit pas autorisé à rester en ligne trop longtemps.

Modération réactive

En modération réactive, la communauté des utilisateurs est encouragée à signaler le contenu inapproprié qui enfreint la communauté règles et directives. Dans cette méthode, l'attention de la communauté est attirée sur le contenu qui nécessite une modération. Cependant, le contenu offensant peut rester sur la plate-forme pendant des périodes plus longues.

Modération distribuée

Dans une méthode de modération distribuée, la communauté en ligne peut examiner, signaler et supprimer le contenu qu'elle trouve offensant et contraire aux directives à l'aide d'un système de notation.

Modération automatisée

Comme son nom l'indique, la modération automatisée utilise divers outils et systèmes pour signaler des mots ou des phrases et rejeter les soumissions. Il fonctionne en filtrant certains mots, images et vidéos interdits à l'aide d'algorithmes d'apprentissage automatique.

Bien que la modération basée sur la technologie se généralise, modération humaine en examen ne peut être ignoré. Idéalement, les entreprises utilisent une combinaison d'outils automatisés et de modérateurs humains, du moins pour les situations complexes.

[A également lu: Étude de cas – Modération du contenu]

Comment le Machine Learning aide-t-il la modération de contenu ?

Avec plus de 5 milliards de personnes utilisant Internet et plus de 4 milliards actifs sur les réseaux sociaux, il n'est pas facile de s'étonner du nombre d'images, de textes, de vidéos, de publications et de messages générés quotidiennement. Ce contenu gigantesque doit être modéré d'une manière ou d'une autre afin que les utilisateurs accédant à leurs sites de médias sociaux puissent vivre une expérience agréable et enrichissante.

La modération de contenu est apparue comme la solution pour supprimer le contenu explicite, offensant, abusif, frauduleux ou contraire à l'éthique de la marque. Traditionnellement, les entreprises se sont entièrement appuyées sur des modérateurs humains pour examiner le contenu en ligne généré par les utilisateurs et publié sur leurs plateformes. Cependant, dépendre entièrement de modérateurs humains peut rendre le processus long, coûteux et inefficace.

Les entreprises utilisent désormais des algorithmes d'apprentissage automatique pour modérer automatiquement et efficacement le contenu. Alimenté par l'IA la modération du contenu a rendu l'ensemble du processus efficace, plus rapide, cohérent et rentable.

Bien que ce processus n'élimine pas le besoin de modérateurs humains - humain dans la boucle, la contribution de modérateurs humains permet de traiter des problèmes complexes. De plus, les modérateurs humains comprennent mieux les nuances linguistiques, les différences culturelles et le contexte. Lorsque des outils automatisés sont utilisés, avec l'aide de modérateurs humains, cela réduit l'impact psychologique de l'exposition au contenu déclencheur.

Défis de la modération de contenu

Un autre défi majeur lorsqu'il s'agit de développer un algorithme de modération de contenu précis est la langue. Une application de modération de contenu fiable doit être capable de reconnaître plusieurs langues et de comprendre les nuances culturelles, les contextes sociaux et le dynamisme linguistique.

Étant donné qu'une langue subit plusieurs changements au fil du temps, comme certains mots innocents hier auraient pu gagner en notoriété aujourd'hui, le modèle ML doit suivre le rythme de l'évolution du monde. Par exemple, une peinture de nu pourrait être explicite et voyeuriste ou simplement de l'art.

Comment un morceau de contenu est perçu ou jugé inapproprié dépend du contexte. Et il est crucial d'avoir une cohérence et des normes au sein de votre plateforme afin que vos utilisateurs puissent faire confiance à vos efforts de modération.

Un utilisateur typique essaie toujours de trouver des failles dans vos directives et de contourner les règles de modération. Cependant, votre algorithme ML doit pouvoir évoluer en permanence avec les temps qui changent.

Enfin, c'est la question du biais. Diversifier votre base de données de formation et vos modèles de formation pour détecter le contexte est essentiel. Bien que développer un algorithme de modération de contenu fiable puisse sembler difficile, cela commence par mettre la main sur des ensembles de données de formation de haute qualité.

Les fournisseurs tiers disposant de l'expertise et de l'expérience nécessaires pour fournir des ensembles de données de formation adéquats sont les bons points de départ.

Chaque entreprise ayant une présence sociale a besoin d'une technologie de pointe solution de modération de contenu qui contribue à renforcer la confiance des clients et une expérience client irréprochable. Pour créer l'application et former votre modèle d'apprentissage automatique, vous devez accéder à une base de données de haute qualité, sans parti pris, alignée sur les dernières tendances linguistiques et de contenu spécifiques au marché.

Avec nos années d'expérience à aider les entreprises à lancer des modèles d'IA, Shai propose des systèmes complets de collecte de données répondant à divers besoins de modération de contenu.