Étude de cas : modération de contenu

Plus de 30 XNUMX documents supprimés et annotés pour la modération de contenu

qui s'efforcent de sécuriser l'espace en ligne où nous nous connectons et communiquons.

Alors que l'utilisation des médias sociaux continue de croître, le

Le problème de la cyberintimidation est apparu comme un

obstacle important pour les plates-formes qui s'efforcent de

assurer un espace en ligne sécurisé. Un stupéfiant

38% des individus rencontrent ce

comportement préjudiciable au quotidien,

soulignant la demande urgente de créativité

approches de modération de contenu.

Aujourd'hui, les organisations comptent sur l'utilisation de

l'intelligence artificielle pour faire face aux problèmes persistants

problème de la cyberintimidation de manière proactive.

La cyber-sécurité:

Le rapport sur l'application des normes communautaires du quatrième trimestre de Facebook a été révélé - action sur 4 millions de contenus d'intimidation et de harcèlement, avec un taux de détection proactive de 6.3 %

L'Education:

A 2021 étude a révélé que 36.5%% des étudiants aux états-unis âgés de 12 & 17 ans ont été victimes de cyberintimidation à un moment ou à un autre de leur scolarité.

Selon un rapport de 2020, le marché mondial des solutions de modération de contenu était évalué à 4.07 milliards USD en 2019 et devrait atteindre 11.94 milliards USD d'ici 2027, avec un TCAC de 14.7 %.

Solution du monde réel

Des données qui modèrent les conversations mondiales

Le client développait un système automatisé robuste

modération de contenu Machine Learning

modèle pour son offre Cloud, pour laquelle ils

recherchaient un fournisseur spécifique à un domaine qui

pourrait les aider avec des données de formation précises.

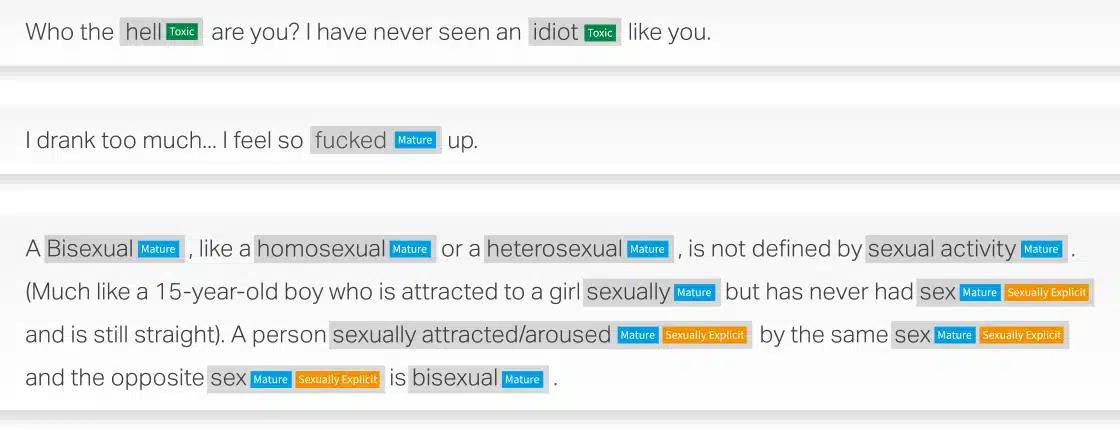

Tirant parti de nos connaissances approfondies en traitement du langage naturel (TAL), nous avons aidé le client à rassembler, catégoriser et annoter plus de 30,000 XNUMX documents en anglais et en espagnol pour créer un modèle d'apprentissage automatique de modération de contenu automatisé divisé en contenu toxique, mature ou sexuellement explicite. catégories.

Problème

- Web scraping 30,000 XNUMX documents en espagnol et en anglais à partir de domaines prioritaires

- Catégoriser le contenu rassemblé en segments courts, moyens et longs

- Étiqueter les données compilées comme étant du contenu toxique, mature ou sexuellement explicite

- Garantir des annotations de haute qualité avec une précision minimale de 90 %.

Solution

- Web Scrapped 30,000 XNUMX documents chacun pour l'espagnol et l'anglais de BFSI, Healthcare, Manufacturing, Retail. Le contenu a ensuite été divisé en documents courts, moyens et longs

- Réussir à étiqueter le contenu classé comme contenu toxique, mature ou sexuellement explicite

- Pour atteindre 90% de qualité, Shaip a mis en place un processus de contrôle qualité à deux niveaux :

» Niveau 1 : Contrôle Assurance Qualité : 100% des dossiers à valider.

» Niveau 2 : Vérification critique de l'analyse de la qualité : l'équipe AQC de Shaips doit évaluer 15 % à 20 % des échantillons rétrospectifs.

Résultat

Les données de formation ont aidé à créer un modèle ML de modération de contenu automatisé qui peut produire plusieurs résultats bénéfiques pour maintenir un environnement en ligne plus sûr. Certains des principaux résultats comprennent :

- Efficacité pour traiter une grande quantité de données

- Cohérence pour assurer une application uniforme des politiques de modération

- Évolutivité pour s'adapter à la croissance de la base d'utilisateurs et des volumes de contenu

- La modération en temps réel peut identifier et

supprimer le contenu potentiellement dangereux au fur et à mesure qu'il est généré - Rentabilité en réduisant la dépendance aux modérateurs humains

Exemples de modération de contenu

Dites-nous comment nous pouvons vous aider avec votre prochaine initiative d'IA.