Dans le domaine en plein essor de l'intelligence artificielle (IA), l'accent mis sur les considérations éthiques et l'équité est plus qu'un impératif moral : c'est une nécessité fondamentale pour la longévité et l'acceptation sociale de la technologie. L’IA éthique, ou Fair AI, vise à garantir que les systèmes d’IA fonctionnent sans préjugés, discrimination ou résultats injustes. Ce blog explore l'importance de l'IA éthique et se penche sur les différents types de préjugés à éviter.

Pourquoi l'IA éthique est importante

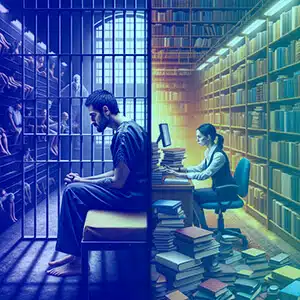

Les systèmes d’IA font de plus en plus partie de notre vie quotidienne, prenant des décisions qui affectent tout, des candidatures à un emploi jusqu’aux condamnations judiciaires. Lorsque ces systèmes sont biaisés, ils peuvent perpétuer et amplifier les inégalités sociétales, causant ainsi du tort aux individus et aux groupes. L’IA éthique vise à prévenir de tels résultats en promouvant l’équité, la responsabilité, la transparence et le respect des droits de l’homme.

Types de biais et exemples

Biais de violence

Les systèmes d’IA doivent être formés pour reconnaître et omettre les contenus violents. Par exemple, un modèle linguistique formé sur des textes violents pourrait générer un contenu préjudiciable, favorisant l’agressivité au lieu d’un dialogue constructif.

Des sujets controversés

Former l’IA sur des sujets controversés sans modération minutieuse peut conduire l’IA à adopter des positions polarisées. Par exemple, une IA entraînée à partir de données sur le droit aux armes à feu pourrait générer des arguments controversés et unilatéraux.

Biais de genre

Un exemple classique de préjugé sexiste est lorsqu’un modèle de langage associe les infirmières aux femmes et les ingénieurs aux hommes, renforçant ainsi des stéréotypes dépassés plutôt que de refléter la diversité de ces professions.

Préjugés raciaux et ethniques

Prenons l’exemple d’une IA qui génère des images de PDG mais les décrit principalement comme appartenant à un seul groupe racial, ignorant ainsi la réalité de la diversité au sein du monde de l’entreprise.

Biais socio-économique

Les systèmes d’IA peuvent privilégier un langage ou des concepts associés à un statut socio-économique plus élevé, par exemple en supposant que les marques de luxe sont la norme en matière de qualité, négligeant ainsi le spectre plus large des expériences de consommation.

Biais lié à l'âge

L’IA pourrait supposer à tort que les références à la technologie ne sont pas pertinentes pour les personnes âgées, les excluant ainsi des conversations sur les avancées numériques.

Biais culturel

Un système d’IA pourrait générer des critiques de restaurants axées sur les cuisines occidentales, ignorant la richesse des autres traditions culinaires et marginalisant ainsi les cultures non occidentales.

Parti pris politique

Une IA programmée pour organiser des articles de presse pourrait sélectionner de manière disproportionnée des articles de l’extrémité gauche ou droite du spectre politique, plutôt que de présenter un point de vue équilibré.

Biais religieux

Si un système d’IA fait référence de manière disproportionnée à une religion sous un jour positif tout en ignorant ou en déformant les autres, il présente un préjugé religieux.

Biais régional

Un modèle linguistique peut générer des rapports de trafic qui ne concernent que les zones urbaines, ignorant les régions rurales ou moins peuplées.

Préjugés liés au handicap

Prenons l’exemple d’un conseiller en santé IA qui ne parvient pas à proposer des options d’exercice accessibles aux personnes handicapées, offrant ainsi des conseils incomplets et exclusifs.

Biais linguistique

Une IA de traduction peut systématiquement fournir des traductions de haute qualité pour certaines langues, mais des traductions de qualité inférieure pour les langues moins représentées dans ses données de formation.

Biais de confirmation

Une IA pourrait amplifier la croyance d'un utilisateur dans un faux remède en faisant référence de manière sélective à des sources qui soutiennent ce remède et en ignorant le consensus scientifique.

Biais contextuel

Une IA peut interpréter les demandes d’informations sur les « prisons » comme une enquête criminelle plutôt que comme une enquête académique ou juridique, selon le contexte dans lequel elle a été formée.

Biais de la source de données

Si les données de formation d’une IA proviennent d’un forum qui discute principalement des réalisations d’un certain groupe démographique, elle peut négliger les contributions d’autres groupes.

Comment éviter ces biais

Éviter ces biais nécessite une approche à plusieurs facettes :

- Divers ensembles de données : Incorporez un large éventail de sources de données pour équilibrer la représentation entre les différents groupes.

- Audit régulier : Effectuer des contrôles continus pour identifier et corriger les préjugés.

- Transparence: Expliquez clairement comment les systèmes d'IA prennent des décisions et sur quelles données ils sont formés.

- Inclusivité dans les équipes d'IA : Des équipes diversifiées peuvent mieux identifier les préjugés potentiels qui pourraient être négligés.

- Formation en éthique : Éduquer les développeurs d’IA sur l’importance des considérations éthiques.

- Commentaires des parties prenantes : Impliquez les utilisateurs et les communautés concernées dans le processus de développement de l’IA.

Pourquoi Shaip

Shaip, en tant que leader des solutions de données d'IA, propose des services complets conçus pour s'attaquer de front aux préjugés de l'IA. En fournissant des ensembles de données diversifiés et équilibrés pour la formation des modèles d'IA, Shaip garantit que vos systèmes d'IA sont exposés à un large éventail d'expériences humaines et de données démographiques, réduisant ainsi le risque de biais sur tous les fronts, du sexe et de la race à la langue et au handicap. Leurs processus rigoureux de conservation et d’annotation des données, associés à un cadre d’IA éthique, peuvent aider les organisations à identifier, atténuer et prévenir l’incorporation de préjugés dans les systèmes d’IA. L'expertise de Shaip dans le développement de modèles sur mesure signifie également qu'il peut aider à créer une IA aussi inclusive, juste et impartiale que possible, conforme aux normes mondiales de l'IA éthique.

Conclusion

L’IA éthique est cruciale pour créer un avenir où la technologie sert l’humanité sans préjugés. En comprenant et en atténuant les préjugés, les développeurs et les parties prenantes peuvent garantir que les systèmes d'IA sont justes et équitables. Il incombe à toutes les personnes impliquées dans le cycle de vie de l’IA de favoriser un environnement dans lequel la technologie reflète nos normes éthiques les plus élevées, promouvant ainsi une société juste et inclusive. Grâce à la vigilance et au respect de ces principes, l’IA peut réaliser son véritable potentiel en tant que force du bien.