Large Language Models (LLM): Guide complet en 2023

Tout ce que vous devez savoir sur le LLM

Table d'index

- Introduction

- Que sont les grands modèles de langage ?

- Facteurs essentiels

- Exemples populaires de LLM

- Blocs de construction des LLM

- Comment les modèles LLM sont-ils formés ?

- LLM s'appuie sur l'apprentissage supervisé ou non supervisé

- Former LLM

- L'essor du LLM

- Cas d'utilisation populaires de LLM

- Sécurité et conformité

- Affiner un LLM

- QFP

Télécharger un livre électronique

Introduction

Vous êtes-vous déjà gratté la tête, étonné de la façon dont Google ou Alexa semblaient vous "avoir" ? Ou vous êtes-vous retrouvé à lire un essai généré par ordinateur qui semble étrangement humain ? Tu n'es pas seul. Il est temps de tirer le rideau et de révéler le secret : les Large Language Models, ou LLM.

Quels sont-ils, demandez-vous? Considérez les LLM comme des assistants cachés. Ils alimentent nos chats numériques, comprennent nos phrases confuses et écrivent même comme nous. Ils transforment nos vies, faisant de la science-fiction une réalité.

Ce guide porte sur tout ce qui concerne LLM. Nous explorerons ce qu'ils peuvent faire, ce qu'ils ne peuvent pas faire et où ils sont utilisés. Nous examinerons leur impact sur nous tous dans un langage clair et simple.

Alors, commençons notre voyage passionnant dans les LLM.

A qui s'adresse ce guide ?

Ce guide complet s'adresse à :

- Vous tous, entrepreneurs et solopreneurs, qui consommez régulièrement des quantités massives de données

- IA et machine learning ou professionnels qui se lancent dans les techniques d'optimisation des processus

- Les chefs de projet qui ont l'intention de mettre en œuvre un délai de mise sur le marché plus rapide pour leurs modules d'IA ou leurs produits pilotés par l'IA

- Et les passionnés de technologie qui aiment entrer dans les détails des couches impliquées dans les processus d'IA.

Que sont les grands modèles de langage ?

Les grands modèles de langage (LLM) sont des systèmes avancés d'intelligence artificielle (IA) conçus pour traiter, comprendre et générer du texte de type humain. Ils sont basés sur des techniques d'apprentissage en profondeur et formés sur des ensembles de données massifs, contenant généralement des milliards de mots provenant de diverses sources telles que des sites Web, des livres et des articles. Cette formation approfondie permet aux LLM de saisir les nuances de la langue, de la grammaire, du contexte et même de certains aspects des connaissances générales.

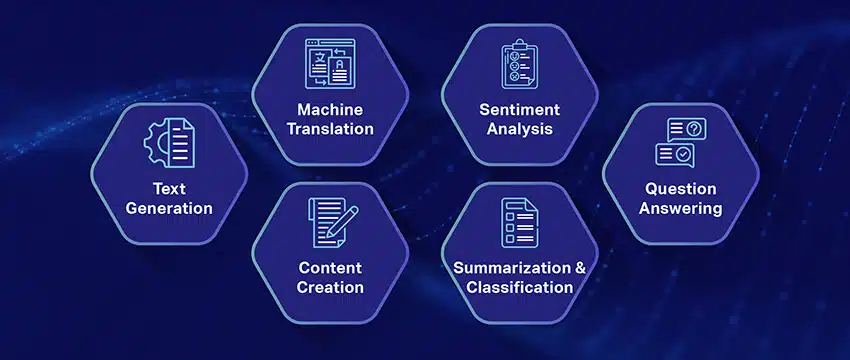

Certains LLM populaires, comme le GPT-3 d'OpenAI, utilisent un type de réseau neuronal appelé transformateur, qui leur permet de gérer des tâches linguistiques complexes avec une compétence remarquable. Ces modèles peuvent effectuer un large éventail de tâches, telles que :

- Répondre à des questions

- Résumé du texte

- Traduire des langues

- Génération de contenu

- Même s'engager dans des conversations interactives avec les utilisateurs

À mesure que les LLM continuent d'évoluer, ils offrent un grand potentiel pour améliorer et automatiser diverses applications dans tous les secteurs, du service client et de la création de contenu à l'éducation et à la recherche. Cependant, ils soulèvent également des préoccupations éthiques et sociétales, telles que les comportements biaisés ou les abus, qui doivent être résolues à mesure que la technologie progresse.

Facteurs essentiels dans la construction d'un corpus de données LLM

Vous devez créer un corpus de données complet pour réussir à entraîner des modèles de langage. Ce processus implique de collecter de vastes données et de garantir leur haute qualité et leur pertinence. Examinons les aspects clés qui influencent de manière significative le développement d'une bibliothèque de données efficace pour la formation de modèles de langage.

Privilégiez la qualité des données plutôt que la quantité

Un grand ensemble de données est fondamental pour former des modèles de langage. Pourtant, la qualité des données revêt une grande importance. Les modèles formés sur des données volumineuses mais mal structurées peuvent donner des résultats inexacts.

À l’inverse, des ensembles de données plus petits et méticuleusement organisés conduisent souvent à des performances supérieures. Cette réalité montre l’importance d’une approche équilibrée en matière de collecte de données. Les données représentatives, diverses et pertinentes par rapport à la portée prévue du modèle nécessitent une sélection, un nettoyage et une organisation minutieux.

Sélectionnez les sources de données appropriées

Le choix des sources de données doit correspondre aux objectifs d'application spécifiques du modèle.

- Les modèles qui génèrent un dialogue bénéficieraient de sources telles que les conversations et les entretiens, qui sont inestimables.

- Les modèles axés sur la génération de code bénéficieront de référentiels de code bien documentés.

- Les œuvres littéraires et les scénarios offrent une richesse de matériel de formation pour ceux qui ciblent l’écriture créative.

Vous devez inclure des données qui couvrent les langues et les sujets prévus. Il vous aide à adapter le modèle pour qu'il fonctionne efficacement dans son domaine désigné.

Utiliser la génération de données synthétiques

L'amélioration de votre ensemble de données avec des données synthétiques peut combler les lacunes et étendre sa portée. Vous pouvez utiliser l'augmentation des données, les modèles de génération de texte et la génération basée sur des règles pour créer des données artificielles qui reflètent des modèles du monde réel. Cette stratégie élargit la diversité de l'ensemble de formation pour améliorer la résilience du modèle et contribuer à réduire les biais.

Assurez-vous de vérifier la qualité des données synthétiques afin qu'elles contribuent positivement à la capacité du modèle à comprendre et à générer du langage dans son domaine cible.

Mettre en œuvre une collecte de données automatisée

L'automatisation du processus de collecte de données facilite l'intégration cohérente de données récentes et pertinentes. Cette approche rationalise l'acquisition de données, améliore l'évolutivité et favorise la reproductibilité.

Vous pouvez collecter efficacement des ensembles de données variés en utilisant des outils de web scraping, des API et des frameworks d'ingestion de données. Vous pouvez affiner ces outils pour vous concentrer sur des données pertinentes et de haute qualité. Ils optimisent le matériel de formation du modèle. Vous devez surveiller en permanence ces systèmes automatisés pour maintenir leur exactitude et leur intégrité éthique.

Exemples populaires de grands modèles de langage

Voici quelques exemples importants de LLM largement utilisés dans différents secteurs verticaux :

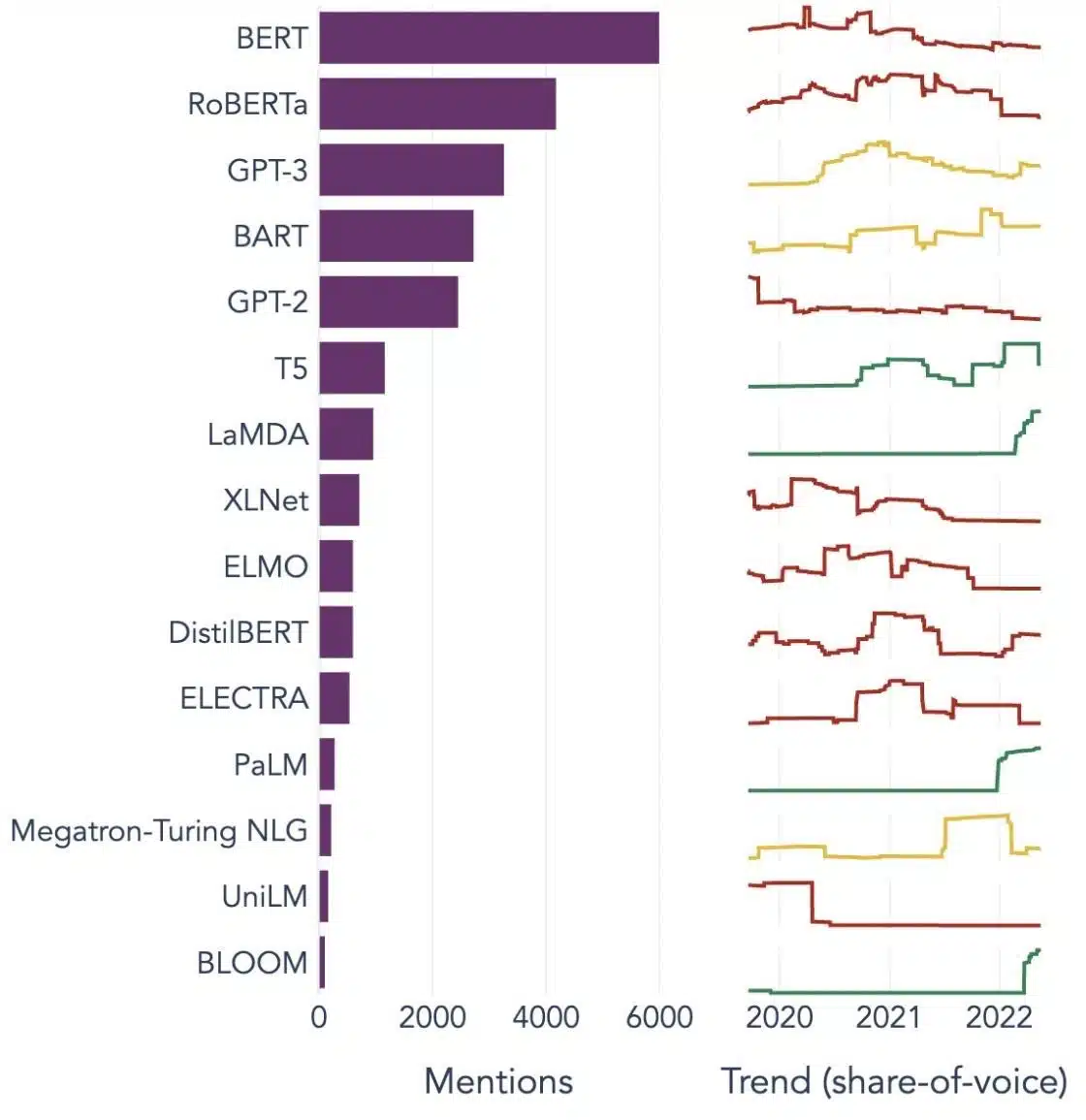

Source de l'image: Vers la science des données

Comprendre les éléments constitutifs des grands modèles de langage (LLM)

Pour bien comprendre les capacités et le fonctionnement des LLM, il est important de se familiariser avec certains concepts clés. Ceux-ci inclus:

Incorporation de mots

Cela fait référence à la pratique consistant à traduire des mots dans un format numérique que les modèles d'IA peuvent interpréter. Essentiellement, l'incorporation de mots est le langage de l'IA. Chaque mot est représenté sous la forme d'un vecteur de grande dimension qui encapsule sa signification sémantique en fonction de son contexte dans les données d'apprentissage. Ces vecteurs permettent à l'IA de comprendre les relations et les similitudes entre les mots, améliorant ainsi la compréhension et les performances du modèle.

Mécanismes d'attention

Ces composants sophistiqués aident le modèle d'IA à prioriser certains éléments du texte d'entrée par rapport à d'autres lors de la génération d'une sortie. Par exemple, dans une phrase remplie de divers sentiments, un mécanisme d'attention pourrait donner plus de poids aux mots porteurs de sentiments. Cette stratégie permet à l'IA de générer des réponses contextuelles plus précises et nuancées.

Transformateurs

Les transformateurs représentent un type avancé d'architecture de réseau neuronal largement utilisé dans la recherche LLM. Ce qui distingue les transformateurs, c'est leur mécanisme d'auto-attention. Ce mécanisme permet au modèle de peser et de considérer toutes les parties des données d'entrée simultanément, plutôt que dans un ordre séquentiel. Le résultat est une amélioration de la gestion des dépendances à longue portée dans le texte, un défi courant dans les tâches de traitement du langage naturel.

Réglage fin

Même les LLM les plus avancés nécessitent une certaine adaptation pour exceller dans des tâches ou des domaines spécifiques. C'est là qu'intervient le réglage fin. Une fois qu'un modèle a été initialement formé sur un grand ensemble de données, il peut être encore affiné, ou "affiné" sur un ensemble de données plus petit et plus spécifique. Ce processus permet au modèle d'adapter ses capacités de compréhension généralisée du langage à une tâche ou à un contexte plus spécialisé.

Ingénierie rapide

Les invites d'entrée servent de point de départ aux LLM pour générer des sorties. L'élaboration efficace de ces invites, une pratique connue sous le nom d'ingénierie des invites, peut grandement influencer la qualité des réponses du modèle. C'est un mélange d'art et de science qui nécessite une compréhension approfondie de la façon dont le modèle interprète les invites et génère des réponses.

Préjugé

Au fur et à mesure que les LLM apprennent des données sur lesquelles ils sont formés, tout biais présent dans ces données peut infiltrer le comportement du modèle. Cela pourrait se manifester par des tendances discriminatoires ou injustes dans les sorties du modèle. Traiter et atténuer ces biais est un défi important dans le domaine de l'IA et un aspect crucial du développement de LLM éthiquement solides.

Interprétabilité

Compte tenu de la complexité des LLM, il peut être difficile de comprendre pourquoi ils prennent certaines décisions ou génèrent des résultats spécifiques. Cette caractéristique, connue sous le nom d'interprétabilité, est un domaine clé de la recherche en cours. L'amélioration de l'interprétabilité facilite non seulement le dépannage et l'affinement des modèles, mais renforce également la confiance et la transparence dans les systèmes d'IA.

Comment les modèles LLM sont-ils formés ?

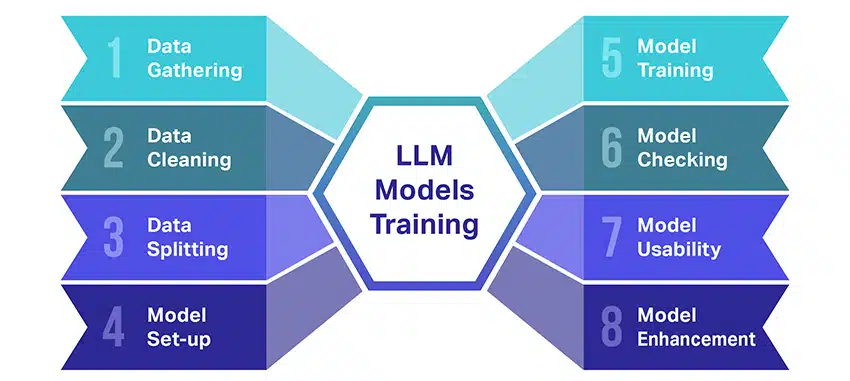

La formation de grands modèles linguistiques (LLM) est tout un exploit qui implique plusieurs étapes cruciales. Voici un aperçu simplifié, étape par étape, du processus :

- Collecte de données textuelles : La formation d'un LLM commence par la collecte d'une grande quantité de données textuelles. Ces données peuvent provenir de livres, de sites Web, d'articles ou de plateformes de médias sociaux. L'objectif est de saisir la riche diversité du langage humain.

- Nettoyer les données : Les données textuelles brutes sont ensuite rangées dans un processus appelé prétraitement. Cela inclut des tâches telles que la suppression des caractères indésirables, la décomposition du texte en parties plus petites appelées jetons et la mise en forme du tout dans un format avec lequel le modèle peut fonctionner.

- Fractionner les données : Ensuite, les données propres sont divisées en deux ensembles. Un ensemble, les données d'entraînement, sera utilisé pour entraîner le modèle. L'autre ensemble, les données de validation, sera utilisé plus tard pour tester les performances du modèle.

- Configuration du modèle : La structure du LLM, appelée architecture, est alors définie. Cela implique de sélectionner le type de réseau de neurones et de décider de divers paramètres, tels que le nombre de couches et d'unités cachées au sein du réseau.

- Entraînement du modèle : La formation proprement dite commence maintenant. Le modèle LLM apprend en examinant les données de formation, en faisant des prédictions basées sur ce qu'il a appris jusqu'à présent, puis en ajustant ses paramètres internes pour réduire la différence entre ses prédictions et les données réelles.

- Vérification du modèle: L'apprentissage du modèle LLM est vérifié à l'aide des données de validation. Cela permet de voir les performances du modèle et d'ajuster les paramètres du modèle pour de meilleures performances.

- Utilisation du modèle: Après formation et évaluation, le modèle LLM est prêt à l'emploi. Il peut maintenant être intégré dans des applications ou des systèmes où il générera du texte basé sur les nouvelles entrées qui lui sont données.

- Amélioration du modèle : Enfin, il y a toujours place à l'amélioration. Le modèle LLM peut être affiné au fil du temps, en utilisant des données mises à jour ou en ajustant les paramètres en fonction des commentaires et de l'utilisation dans le monde réel.

N'oubliez pas que ce processus nécessite des ressources de calcul importantes, telles que des unités de traitement puissantes et un stockage important, ainsi que des connaissances spécialisées en apprentissage automatique. C'est pourquoi elle est généralement effectuée par des organismes de recherche spécialisés ou des entreprises ayant accès à l'infrastructure et à l'expertise nécessaires.

Le LLM repose-t-il sur un apprentissage supervisé ou non supervisé?

Les grands modèles de langage sont généralement entraînés à l'aide d'une méthode appelée apprentissage supervisé. En termes simples, cela signifie qu'ils apprennent à partir d'exemples qui leur montrent les bonnes réponses.

Ainsi, si vous donnez une phrase à un LLM, il essaie de prédire le mot ou la phrase suivante en fonction de ce qu'il a appris des exemples. De cette façon, il apprend à générer un texte qui a du sens et s'adapte au contexte.

Cela dit, parfois, les LLM utilisent également un peu d'apprentissage non supervisé. C'est comme laisser l'enfant explorer une pièce pleine de jouets différents et apprendre à les connaître par lui-même. Le modèle examine les données non étiquetées, les modèles d'apprentissage et les structures sans se voir dire les «bonnes» réponses.

L'apprentissage supervisé utilise des données étiquetées avec des entrées et des sorties, contrairement à l'apprentissage non supervisé, qui n'utilise pas de données de sortie étiquetées.

En un mot, les LLM sont principalement formés à l'aide d'un apprentissage supervisé, mais ils peuvent également utiliser un apprentissage non supervisé pour améliorer leurs capacités, par exemple pour l'analyse exploratoire et la réduction de la dimensionnalité.

Quel est le volume de données (en Go) nécessaire pour former un grand modèle de langage ?

Le monde des possibilités pour la reconnaissance des données vocales et les applications vocales est immense, et elles sont utilisées dans plusieurs industries pour une pléthore d'applications.

La formation d'un grand modèle de langage n'est pas un processus unique, en particulier en ce qui concerne les données nécessaires. Cela dépend d'un tas de choses :

- La conception du modèle.

- Quel travail doit-il faire?

- Le type de données que vous utilisez.

- À quel point voulez-vous qu'il fonctionne ?

Cela dit, la formation des LLM nécessite généralement une quantité massive de données textuelles. Mais de quelle masse parle-t-on ? Eh bien, pensez bien au-delà des gigaoctets (Go). Nous examinons généralement des téraoctets (To) ou même des pétaoctets (Po) de données.

Considérez GPT-3, l'un des plus grands LLM du moment. Il est formé sur 570 Go de données texte. Les LLM plus petits peuvent avoir besoin de moins - peut-être 10-20 Go ou même 1 Go de gigaoctets - mais c'est quand même beaucoup.

Mais il ne s'agit pas seulement de la taille des données. La qualité compte aussi. Les données doivent être propres et variées pour aider le modèle à apprendre efficacement. Et vous ne pouvez pas oublier les autres pièces clés du puzzle, comme la puissance de calcul dont vous avez besoin, les algorithmes que vous utilisez pour la formation et la configuration matérielle dont vous disposez. Tous ces facteurs jouent un rôle important dans la formation d'un LLM.

L'essor des grands modèles de langage : pourquoi ils sont importants

Les LLM ne sont plus seulement un concept ou une expérience. Ils jouent de plus en plus un rôle essentiel dans notre paysage numérique. Mais pourquoi cela se produit-il ? Qu'est-ce qui rend ces LLM si importants? Examinons quelques facteurs clés.

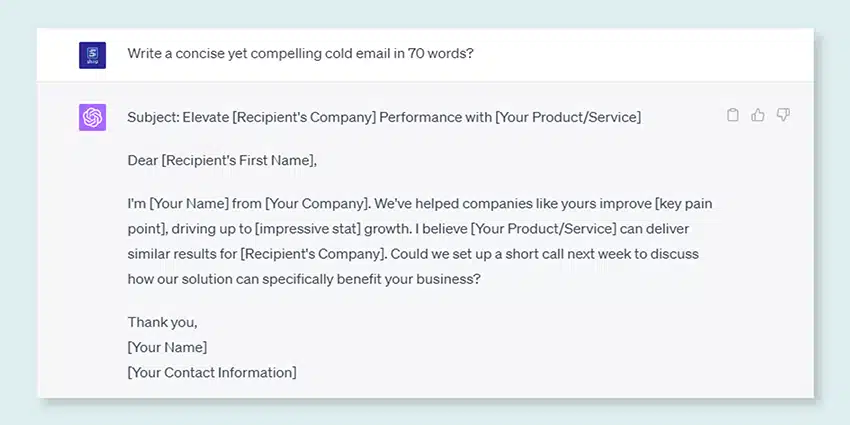

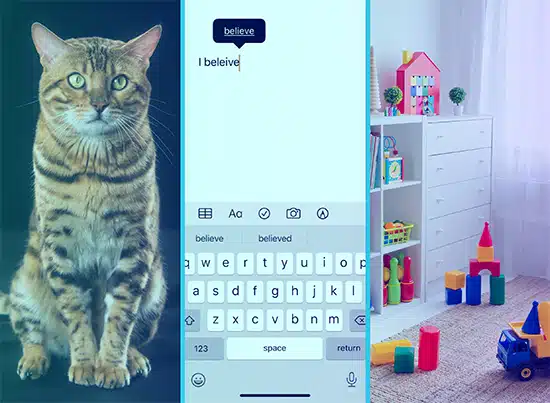

Maîtrise de l'imitation de texte humain

Les LLM ont transformé la façon dont nous gérons les tâches linguistiques. Construits à l'aide d'algorithmes d'apprentissage automatique robustes, ces modèles sont dotés de la capacité de comprendre les nuances du langage humain, y compris le contexte, l'émotion et même le sarcasme, dans une certaine mesure. Cette capacité à imiter le langage humain n'est pas une simple nouveauté, elle a des implications importantes.

Les capacités avancées de génération de texte des LLM peuvent tout améliorer, de la création de contenu aux interactions avec le service client.

Imaginez pouvoir poser à un assistant numérique une question complexe et obtenir une réponse non seulement logique, mais également cohérente, pertinente et livrée sur un ton conversationnel. C'est ce que permettent les LLM. Ils alimentent une interaction homme-machine plus intuitive et engageante, enrichissent les expériences utilisateur et démocratisent l'accès à l'information.

Puissance de calcul abordable

L'essor des LLM n'aurait pas été possible sans des développements parallèles dans le domaine de l'informatique. Plus précisément, la démocratisation des ressources informatiques a joué un rôle important dans l'évolution et l'adoption des LLM.

Les plates-formes basées sur le cloud offrent un accès sans précédent à des ressources informatiques hautes performances. De cette façon, même les petites organisations et les chercheurs indépendants peuvent former des modèles d'apprentissage automatique sophistiqués.

De plus, les améliorations des unités de traitement (comme les GPU et les TPU), combinées à l'essor de l'informatique distribuée, ont rendu possible l'entraînement de modèles avec des milliards de paramètres. Cette accessibilité accrue de la puissance de calcul permet la croissance et le succès des LLM, conduisant à plus d'innovation et d'applications dans le domaine.

Changer les préférences des consommateurs

Les consommateurs d'aujourd'hui ne veulent pas seulement des réponses ; ils veulent des interactions engageantes et pertinentes. À mesure que de plus en plus de personnes grandissent en utilisant la technologie numérique, il est évident que le besoin d'une technologie qui semble plus naturelle et plus humaine augmente. Les LLM offrent une opportunité inégalée de répondre à ces attentes. En générant un texte de type humain, ces modèles peuvent créer des expériences numériques attrayantes et dynamiques, ce qui peut accroître la satisfaction et la fidélité des utilisateurs. Qu'il s'agisse de chatbots IA fournissant un service client ou d'assistants vocaux fournissant des mises à jour, les LLM inaugurent une ère d'IA qui nous comprend mieux.

La mine d'or des données non structurées

Les données non structurées, telles que les e-mails, les publications sur les réseaux sociaux et les avis des clients, sont une mine d'informations. On estime que plus 80% des données d'entreprise ne sont pas structurées et croissent à un rythme 55% par an. Ces données sont une mine d'or pour les entreprises si elles sont exploitées correctement.

Les LLM entrent en jeu ici, avec leur capacité à traiter et à donner un sens à ces données à grande échelle. Ils peuvent gérer des tâches telles que l'analyse des sentiments, la classification de texte, l'extraction d'informations, etc., fournissant ainsi des informations précieuses.

Qu'il s'agisse d'identifier les tendances à partir des publications sur les réseaux sociaux ou d'évaluer le sentiment des clients à partir des avis, les LLM aident les entreprises à naviguer dans la grande quantité de données non structurées et à prendre des décisions basées sur les données.

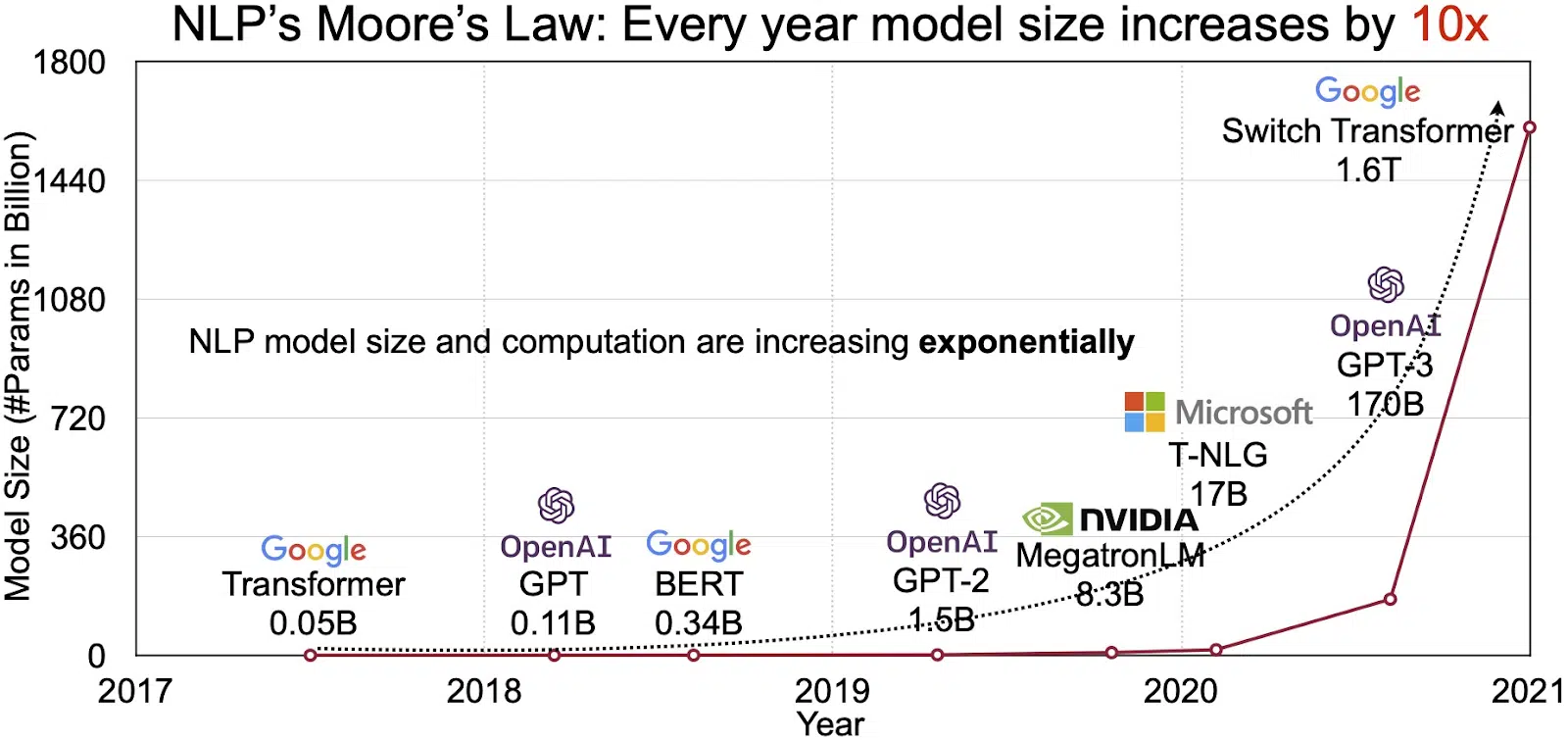

Le marché en expansion de la PNL

Le potentiel des LLM se reflète dans le marché en croissance rapide du traitement du langage naturel (TAL). Les analystes prévoient que le marché de la PNL passera de 11 milliards de dollars en 2020 à plus de 35 milliards de dollars d'ici 2026. Mais ce n'est pas seulement la taille du marché qui s'étend. Les modèles eux-mêmes se développent également, à la fois en taille physique et en nombre de paramètres qu'ils gèrent. L'évolution des LLM au fil des ans, comme le montre la figure ci-dessous (source de l'image : lien), souligne leur complexité et leur capacité croissantes.

Cas d'utilisation populaires des grands modèles de langage

Voici quelques-uns des cas d'utilisation les plus courants et les plus répandus de LLM :

- Génération de texte en langage naturel : Les grands modèles de langage (LLM) combinent la puissance de l'intelligence artificielle et de la linguistique computationnelle pour produire de manière autonome des textes en langage naturel. Ils peuvent répondre à divers besoins des utilisateurs, tels que rédiger des articles, créer des chansons ou engager des conversations avec les utilisateurs.

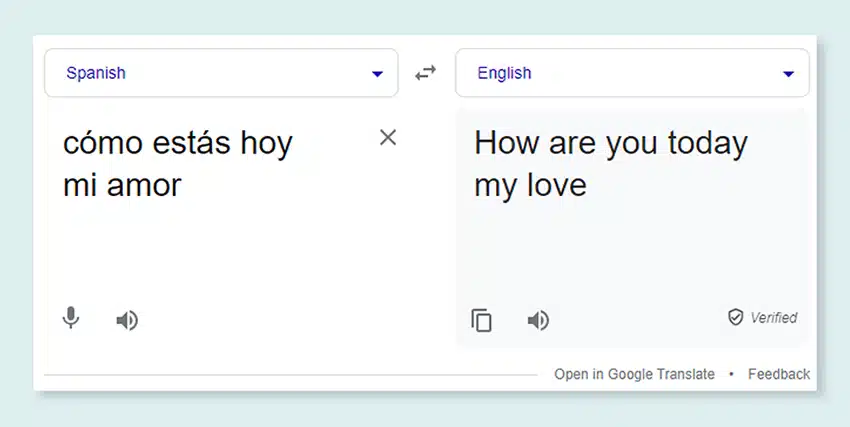

- Traduction par les machines : Les LLM peuvent être utilisés efficacement pour traduire du texte entre n'importe quelle paire de langues. Ces modèles exploitent des algorithmes d'apprentissage en profondeur comme les réseaux de neurones récurrents pour comprendre la structure linguistique des langues source et cible, facilitant ainsi la traduction du texte source dans la langue souhaitée.

- Créer du contenu original : Les LLM ont ouvert la voie aux machines pour générer un contenu cohérent et logique. Ce contenu peut être utilisé pour créer des articles de blog, des articles et d'autres types de contenu. Les modèles puisent dans leur profonde expérience d'apprentissage en profondeur pour formater et structurer le contenu d'une manière nouvelle et conviviale.

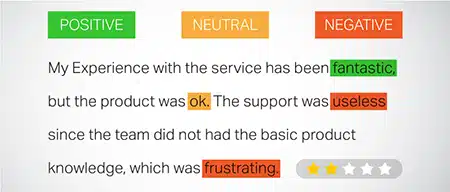

- Analyser les sentiments : Une application intrigante des grands modèles de langage est l'analyse des sentiments. En cela, le modèle est formé pour reconnaître et catégoriser les états émotionnels et les sentiments présents dans le texte annoté. Le logiciel peut identifier des émotions telles que la positivité, la négativité, la neutralité et d'autres sentiments complexes. Cela peut fournir des informations précieuses sur les commentaires et les opinions des clients sur divers produits et services.

- Comprendre, résumer et classer un texte : Les LLM établissent une structure viable pour que les logiciels d'IA interprètent le texte et son contexte. En demandant au modèle de comprendre et d'examiner de grandes quantités de données, les LLM permettent aux modèles d'IA de comprendre, de résumer et même de catégoriser le texte sous diverses formes et modèles.

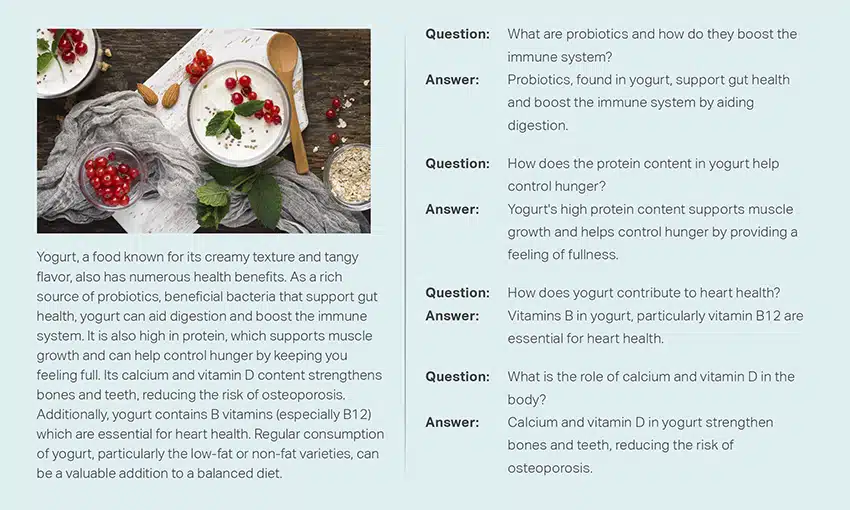

- Répondre à des questions: Les grands modèles de langage équipent les systèmes de réponse aux questions (QA) de la capacité de percevoir et de répondre avec précision à la requête en langage naturel d'un utilisateur. Des exemples populaires de ce cas d'utilisation incluent ChatGPT et BERT, qui examinent le contexte d'une requête et passent au crible une vaste collection de textes pour fournir des réponses pertinentes aux questions des utilisateurs.

Intégration de la sécurité et de la conformité dans les stratégies de données LLM

L'intégration de mesures robustes de sécurité et de conformité dans les cadres de collecte et de traitement des données LLM peut vous aider à garantir une utilisation transparente, sûre et éthique des données. Cette démarche englobe plusieurs actions clés :

- Implémenter un chiffrement robuste: Protégez les données au repos et en transit à l’aide de méthodes de cryptage fortes. Cette étape protège les informations contre les accès non autorisés et les violations.

- Établir des contrôles d’accès et une authentification: Mettre en place des systèmes pour vérifier l’identité des utilisateurs et restreindre l’accès aux données. Cela garantira que seul le personnel autorisé peut interagir avec des informations sensibles.

- Intégrer des systèmes de journalisation et de surveillance: Déployez des systèmes pour suivre l’utilisation des données et identifier les menaces de sécurité potentielles. Cette surveillance proactive contribue à maintenir l’intégrité et la sécurité de l’écosystème de données.

- Adhérer aux normes de conformité: Suivez les réglementations pertinentes telles que le RGPD, la HIPAA et la PCI DSS, qui régissent la sécurité et la confidentialité des données. Des audits et des contrôles réguliers vérifient la conformité, garantissant que les pratiques répondent aux normes juridiques et éthiques spécifiques au secteur.

- Définir des directives d’utilisation éthique des données: Élaborer et appliquer des politiques qui dictent une utilisation équitable, transparente et responsable des données. Ces lignes directrices aident à maintenir la confiance des parties prenantes et à soutenir un environnement de formation sécurisé pour les LLM.

Ces actions renforcent collectivement les pratiques de gestion des données pour la formation LLM. Il construit une base de confiance et de sécurité qui profite à toutes les parties prenantes impliquées.

Affiner un grand modèle de langage

La mise au point d'un grand modèle de langage implique un processus d'annotation méticuleux. Shaip, avec son expertise dans ce domaine, peut contribuer de manière significative à cette entreprise. Voici quelques méthodes d'annotation utilisées pour former des modèles comme ChatGPT :

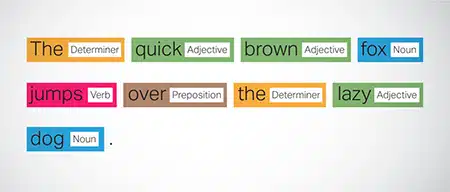

Balisage de la partie du discours (POS)

Les mots dans les phrases sont étiquetés avec leur fonction grammaticale, comme les verbes, les noms, les adjectifs, etc. Ce processus aide le modèle à comprendre la grammaire et les liens entre les mots.

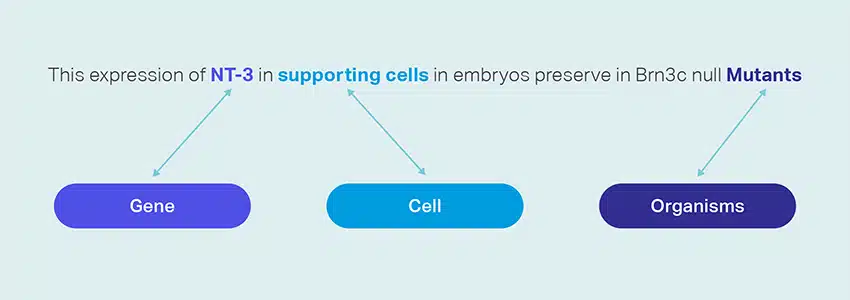

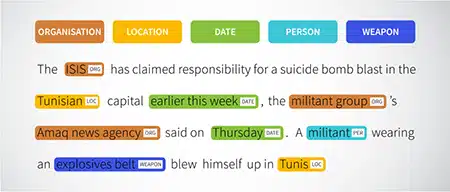

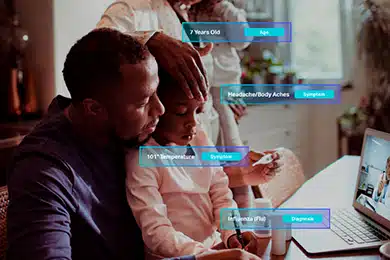

Reconnaissance des entités nommées (NER)

Les entités nommées telles que les organisations, les lieux et les personnes dans une phrase sont marquées. Cet exercice aide le modèle à interpréter les significations sémantiques des mots et des phrases et fournit des réponses plus précises.

Analyse des sentiments

Les données textuelles se voient attribuer des étiquettes de sentiment telles que positif, neutre ou négatif, aidant le modèle à saisir la nuance émotionnelle des phrases. Il est particulièrement utile pour répondre aux requêtes impliquant des émotions et des opinions.

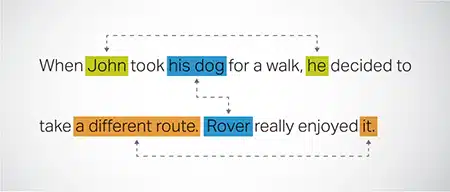

Résolution de coréférence

Identifier et résoudre les cas où la même entité est mentionnée dans différentes parties d'un texte. Cette étape aide le modèle à comprendre le contexte de la phrase, conduisant ainsi à des réponses cohérentes.

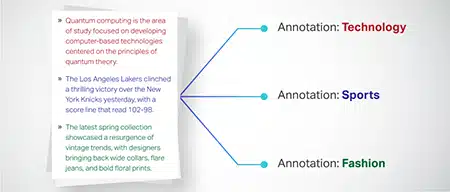

Classification du texte

Les données textuelles sont classées dans des groupes prédéfinis, tels que des critiques de produits ou des articles de presse. Cela aide le modèle à discerner le genre ou le sujet du texte, générant des réponses plus pertinentes.

Shai peut collecter des données de formation via l'exploration Web de divers secteurs tels que la banque, l'assurance, la vente au détail et les télécommunications. Nous pouvons fournir des annotations de texte (NER, analyse des sentiments, etc.), faciliter le LLM multilingue (traduction) et aider à la création de taxonomie, à l'extraction/à l'ingénierie des invites.

Shaip dispose d'un vaste référentiel d'ensembles de données prêts à l'emploi. Notre catalogue de données médicales propose une vaste collection de données anonymisées, sécurisées et de qualité adaptées aux initiatives d'IA, aux modèles d'apprentissage automatique et au traitement du langage naturel.

De même, notre catalogue de données vocales est un trésor de données de haute qualité, parfait pour les produits de reconnaissance vocale, permettant une formation efficace des modèles AI/ML. Nous disposons également d'un impressionnant catalogue de données de vision par ordinateur avec une large gamme de données d'images et de vidéos pour diverses applications.

Nous proposons même gratuitement des ensembles de données ouverts sous une forme modifiable et pratique, à utiliser dans vos projets d'IA et de ML. Cette vaste bibliothèque de données d'IA vous permet de développer vos modèles d'IA et de ML avec plus d'efficacité et de précision.

Processus de collecte et d'annotation des données de Shaip

En ce qui concerne la collecte et l'annotation des données, Shai suit un flux de travail rationalisé. Voici à quoi ressemble le processus de collecte de données :

Identification des sites Web sources

Dans un premier temps, les sites Web sont identifiés à l'aide de sources sélectionnées et de mots-clés pertinents pour les données requises.

Web Scraping

Une fois les sites Web pertinents identifiés, Shaip utilise son outil propriétaire pour récupérer les données de ces sites.

Prétraitement du texte

Les données collectées subissent un traitement initial, qui comprend la division et l'analyse des phrases, ce qui les rend adaptées aux étapes suivantes.

Annotation

Les données prétraitées sont annotées pour l'extraction d'entité nommée. Ce processus implique l'identification et l'étiquetage des éléments importants dans le texte, comme les noms de personnes, d'organisations, de lieux, etc.

Extraction de relations

Dans la dernière étape, les types de relations entre les entités identifiées sont déterminés et annotés en conséquence. Cela aide à comprendre les connexions sémantiques entre les différentes composantes du texte.

Offrande de Shaip

Shai offre une large gamme de services pour aider les organisations à gérer, analyser et tirer le meilleur parti de leurs données.

Web-scraping de données

L'un des services clés offerts par Shaip est le grattage des données. Cela implique l'extraction de données à partir d'URL spécifiques à un domaine. En utilisant des outils et des techniques automatisés, Shaip peut rapidement et efficacement récupérer de gros volumes de données à partir de divers sites Web, manuels de produits, documentation technique, forums en ligne, avis en ligne, données du service client, documents réglementaires de l'industrie, etc. Ce processus peut être inestimable pour les entreprises lorsque la collecte de données pertinentes et spécifiques à partir d'une multitude de sources.

Traduction automatique

Développez des modèles à l'aide de vastes ensembles de données multilingues associés aux transcriptions correspondantes pour la traduction de texte dans différentes langues. Ce processus permet de démanteler les barrières linguistiques et favorise l'accessibilité de l'information.

Extraction et création de taxonomie

Shaip peut aider à l'extraction et à la création de taxonomie. Cela implique de classer et de catégoriser les données dans un format structuré qui reflète les relations entre les différents points de données. Cela peut être particulièrement utile pour les entreprises dans l'organisation de leurs données, les rendant plus accessibles et plus faciles à analyser. Par exemple, dans une entreprise de commerce électronique, les données sur les produits peuvent être classées en fonction du type de produit, de la marque, du prix, etc., ce qui facilite la navigation des clients dans le catalogue de produits.

Collecte des Données

Nos services de collecte de données fournissent des données critiques du monde réel ou synthétiques nécessaires à la formation d'algorithmes d'IA générative et à l'amélioration de la précision et de l'efficacité de vos modèles. Les données sont impartiales, obtenues de manière éthique et responsable tout en gardant à l'esprit la confidentialité et la sécurité des données.

Questions et réponses

La réponse aux questions (QA) est un sous-domaine du traitement du langage naturel axé sur la réponse automatique aux questions en langage humain. Les systèmes d'assurance qualité sont formés sur du texte et du code étendus, ce qui leur permet de traiter divers types de questions, y compris des questions factuelles, définitionnelles et basées sur des opinions. La connaissance du domaine est cruciale pour développer des modèles d'assurance qualité adaptés à des domaines spécifiques tels que le support client, la santé ou la chaîne d'approvisionnement. Cependant, les approches d'AQ génératives permettent aux modèles de générer du texte sans connaissance du domaine, en s'appuyant uniquement sur le contexte.

Notre équipe de spécialistes peut étudier méticuleusement des documents ou des manuels complets pour générer des paires Question-Réponse, facilitant la création d'IA générative pour les entreprises. Cette approche peut répondre efficacement aux demandes des utilisateurs en extrayant des informations pertinentes à partir d'un vaste corpus. Nos experts certifiés assurent la production de paires de questions-réponses de qualité supérieure couvrant divers sujets et domaines.

Synthèse de texte

Nos spécialistes sont capables de distiller des conversations complètes ou de longs dialogues, en fournissant des résumés succincts et perspicaces à partir de données textuelles étendues.

Génération de texte

Entraînez des modèles à l'aide d'un large ensemble de données de texte dans divers styles, comme des articles de presse, de la fiction et de la poésie. Ces modèles peuvent ensuite générer divers types de contenu, y compris des articles d'actualité, des entrées de blog ou des publications sur les réseaux sociaux, offrant une solution rentable et rapide pour la création de contenu.

Reconnaissance vocale

Développer des modèles capables de comprendre le langage parlé pour diverses applications. Cela inclut les assistants à commande vocale, les logiciels de dictée et les outils de traduction en temps réel. Le processus implique l'utilisation d'un ensemble de données complet composé d'enregistrements audio de la langue parlée, associés à leurs transcriptions correspondantes.

Recommandations de produits

Développez des modèles à l'aide de vastes ensembles de données sur les historiques d'achat des clients, y compris des étiquettes indiquant les produits que les clients sont enclins à acheter. L'objectif est de fournir des suggestions précises aux clients, ce qui stimule les ventes et améliore la satisfaction des clients.

Sous-titrage d'images

Révolutionnez votre processus d'interprétation d'images avec notre service de pointe de sous-titrage d'images basé sur l'IA. Nous insufflons de la vitalité aux images en produisant des descriptions précises et contextuellement significatives. Cela ouvre la voie à des possibilités innovantes d'engagement et d'interaction avec votre contenu visuel pour votre public.

Services de synthèse vocale

Nous fournissons un vaste ensemble de données composé d'enregistrements audio de la parole humaine, idéal pour la formation de modèles d'IA. Ces modèles sont capables de générer des voix naturelles et engageantes pour vos applications, offrant ainsi une expérience sonore distinctive et immersive à vos utilisateurs.

Notre catalogue de données diversifié est conçu pour répondre à de nombreux cas d'utilisation de l'IA générative

Catalogue de données médicales et licences standard :

- Plus de 5 millions de dossiers et de fichiers audio de médecins dans 31 spécialités

- Plus de 2 millions d'images médicales en radiologie et autres spécialités (IRM, CT, USG, XR)

- Plus de 30 XNUMX documents de texte cliniques avec entités à valeur ajoutée et annotation des relations

Catalogue de données vocales standard et licence :

- Plus de 40 50 heures de données vocales (plus de 100 langues/XNUMX+ dialectes)

- 55+ sujets traités

- Taux d'échantillonnage – 8/16/44/48 kHz

- Type audio - Spontané, scénarisé, monologue, mots d'éveil

- Ensembles de données audio entièrement transcrits dans plusieurs langues pour la conversation homme-homme, homme-bot, conversation de centre d'appel homme-agent, monologues, discours, podcasts, etc.

Catalogue de données d'images et de vidéos et licences :

- Collection d'images d'aliments/documents

- Collection de vidéos sur la sécurité domestique

- Collection d'images/vidéos faciales

- Factures, bons de commande, reçus Collection de documents pour OCR

- Collection d'images pour la détection des dommages aux véhicules

- Collection d'images de plaques d'immatriculation de véhicules

- Collection d'images d'intérieur de voiture

- Collection d'images avec conducteur de voiture au point

- Collection d'images liées à la mode

Contactez nous

Foire Aux Questions (FAQ)

DL est un sous-domaine de ML qui utilise des réseaux de neurones artificiels à plusieurs couches pour apprendre des modèles complexes dans les données. Le ML est un sous-ensemble de l'IA qui se concentre sur les algorithmes et les modèles qui permettent aux machines d'apprendre à partir des données. Les grands modèles de langage (LLM) sont un sous-ensemble de l'apprentissage en profondeur et partagent un terrain d'entente avec l'IA générative, car les deux sont des composants du domaine plus large de l'apprentissage en profondeur.

Les grands modèles de langage, ou LLM, sont des modèles de langage étendus et polyvalents qui sont initialement pré-formés sur des données textuelles étendues pour saisir les aspects fondamentaux du langage. Ils sont ensuite affinés pour des applications ou des tâches spécifiques, ce qui leur permet d'être adaptés et optimisés à des fins particulières.

Premièrement, les grands modèles de langage possèdent la capacité de gérer un large éventail de tâches en raison de leur formation approfondie avec des quantités massives de données et des milliards de paramètres.

Deuxièmement, ces modèles présentent une adaptabilité car ils peuvent être affinés avec un minimum de données de formation spécifiques sur le terrain.

Enfin, la performance des LLM montre une amélioration continue lorsque des données et des paramètres supplémentaires sont incorporés, améliorant leur efficacité au fil du temps.

La conception d'invites implique la création d'une invite adaptée à la tâche spécifique, telle que la spécification de la langue de sortie souhaitée dans une tâche de traduction. L'ingénierie rapide, quant à elle, se concentre sur l'optimisation des performances en incorporant la connaissance du domaine, en fournissant des exemples de sortie ou en utilisant des mots-clés efficaces. La conception rapide est un concept général, tandis que l'ingénierie rapide est une approche spécialisée. Alors qu'une conception rapide est essentielle pour tous les systèmes, une ingénierie rapide devient cruciale pour les systèmes nécessitant une précision ou des performances élevées.

Il existe trois types de grands modèles de langage. Chaque type nécessite une approche différente de la promotion.

- Les modèles de langue génériques prédisent le mot suivant en fonction de la langue dans les données d'apprentissage.

- Les modèles réglés sur les instructions sont formés pour prédire la réponse aux instructions données dans l'entrée.

- Les modèles adaptés au dialogue sont formés pour avoir une conversation de type dialogue en générant la réponse suivante.